웹 크롤링의 기본 개념 이해하기

웹 크롤링은 인터넷에서 자동화된 방식으로 데이터를 수집하는 과정을 말합니다. 웹 크롤링 프로그램은 웹 페이지를 자동으로 탐색하고 필요한 정보를 추출하여 저장합니다. 이 기술은 데이터 분석, 검색 엔진 최적화, 가격 비교 등 다양한 분야에서 활용됩니다.

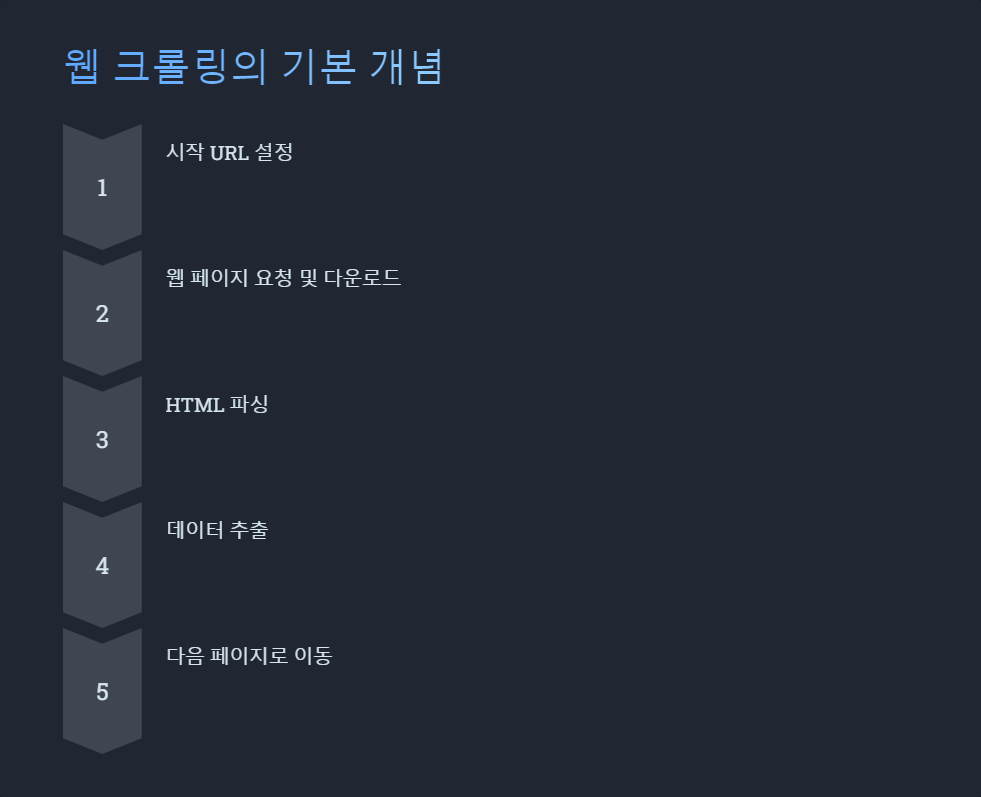

웹 크롤링의 기본 원리는 다음과 같습니다:

이러한 과정을 통해 웹 크롤링 프로그램은 대량의 데이터를 효율적으로 수집할 수 있습니다.

크롤링 프로그램 제작 의뢰 시 고려사항

웹 크롤링 프로그램 제작을 의뢰할 때는 다음과 같은 사항을 고려해야 합니다:

이러한 고려사항을 바탕으로 의뢰 내용을 상세히 작성하면, 더 정확하고 효율적인 웹 크롤링 프로그램을 제작받을 수 있습니다.

효과적인 웹 크롤링을 위한 기술적 요소

효과적인 웹 크롤링 프로그램 제작을 위해서는 다음과 같은 기술적 요소를 고려해야 합니다:

이러한 기술적 요소들을 적절히 조합하여 사용하면, 안정적이고 효율적인 웹 크롤링 프로그램을 제작할 수 있습니다.

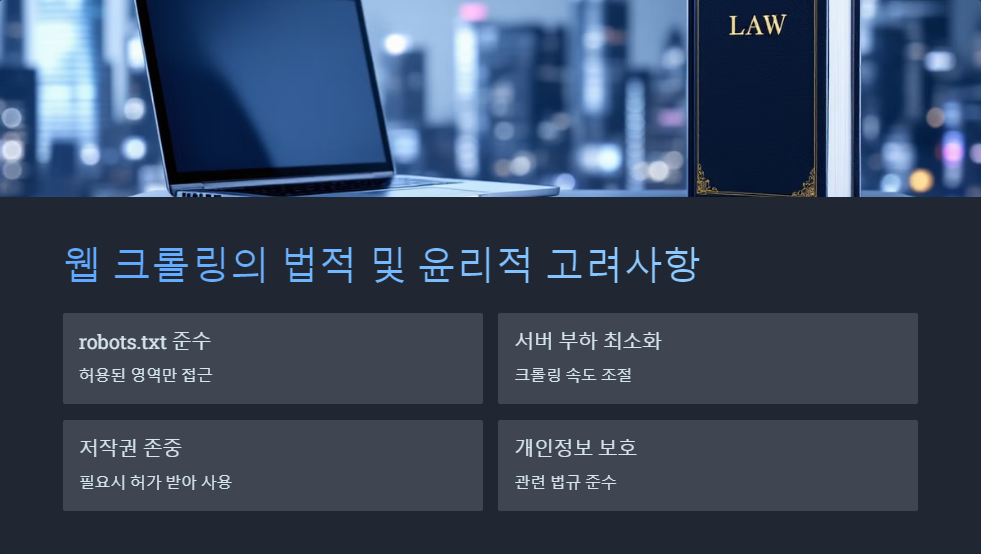

웹 크롤링의 법적 및 윤리적 고려사항

웹 크롤링 프로그램을 제작하고 운영할 때는 다음과 같은 법적, 윤리적 사항을 반드시 고려해야 합니다:

이러한 고려사항을 준수함으로써, 법적 문제를 예방하고 윤리적인 웹 크롤링을 수행할 수 있습니다.

Q&A

Q: 웹 크롤링 프로그램 제작 비용은 어떻게 책정되나요?

A: 웹 크롤링 프로그램의 제작 비용은 프로젝트의 복잡성, 데이터 양, 크롤링 대상 웹사이트의 특성 등에 따라 다양하게 책정됩니다. 일반적으로 간단한 크롤링 프로그램의 경우 30만원부터 시작하며, 복잡한 프로젝트의 경우 수백만원까지 올라갈 수 있습니다. 정확한 견적을 위해서는 구체적인 요구사항을 바탕으로 개발자와 상담하는 것이 좋습니다.

Q: 웹 크롤링 프로그램 제작 시 주의해야 할 점은 무엇인가요?

A: 웹 크롤링 프로그램 제작 시 주의해야 할 주요 사항은 다음과 같습니다:

Q: 웹 크롤링 프로그램 제작에 얼마나 시간이 걸리나요?

A: 웹 크롤링 프로그램의 제작 기간은 프로젝트의 복잡성과 규모에 따라 다양합니다. 간단한 크롤링 프로그램의 경우 2-3일 정도면 완성할 수 있지만, 복잡한 웹사이트를 대상으로 하거나 대량의 데이터를 처리해야 하는 경우에는 2주에서 1달 이상 소요될 수 있습니다. 정확한 일정은 구체적인 요구사항과 개발자의 경험, 가용 리소스 등을 고려하여 산정해야 합니다.

웹 크롤링 프로그램 제작은 데이터 수집 자동화를 통해 비즈니스 효율성을 크게 향상시킬 수 있는 강력한 도구입니다. 하지만 동시에 법적, 윤리적 책임을 수반하므로 신중하게 접근해야 합니다. 전문 개발자와의 협업을 통해 목적에 맞는 효율적이고 안전한 웹 크롤링 프로그램을 제작하여, 데이터 기반의 의사결정과 비즈니스 성장에 활용하시기 바랍니다.

프로그램 의뢰 및 질문은 아래 버튼을 클릭하여 문의해 주세요!

문의하기'이야기' 카테고리의 다른 글

| 최신 색인 프로그램 업데이트 (0) | 2024.12.26 |

|---|---|

| 카페 자동 가입 프로그램 효과적인 활용법 (1) | 2024.12.26 |

| 파이썬 개발로 만드는 맞춤형 자동화 프로그램 (0) | 2024.12.26 |

| 고객 데이터 수집 방법 마케팅 성공 전략 가이드 (1) | 2024.12.26 |

| 2024년 자동 로그인 프로그램 제작 의뢰 방법과 주의사항 (0) | 2024.12.25 |